ในยุคที่ AI กำลังเปลี่ยนแปลงโลกอย่างรวดเร็ว LlamaCon 2025 ได้กลายเป็นเวทีสำคัญที่รวบรวมเสียงจากผู้เชี่ยวชาญและชุมชนนักพัฒนาเพื่อแบ่งปันวิสัยทัศน์และนวัตกรรมล่าสุดของ AI โดยเฉพาะอย่างยิ่งกับโมเดล Llama ซึ่งเป็นโมเดล AI แบบเปิด (open source) ที่ได้รับความนิยมอย่างสูงในช่วงสองปีที่ผ่านมา บทความนี้จะพาไปสำรวจแนวคิดและเทคโนโลยีที่เปิดตัวในงาน พร้อมกับวิเคราะห์ความสำคัญและทิศทางของ AI ในอนาคตที่กำลังจะมาถึง

จุดเริ่มต้นของ Open Source AI และความท้าทายในอดีต

เมื่อสองปีก่อน แนวคิดเรื่อง AI แบบเปิดยังถูกมองว่าเป็นเรื่องไกลตัวและเสี่ยง หลายคนตั้งคำถามถึงความคุ้มค่าทางการเงินและความปลอดภัยของการเปิดเผยโมเดล AI ที่เทรนด้วยทรัพยากรจำนวนมาก โดยเฉพาะความกังวลว่าการเปิดโมเดลอาจทำให้เทคโนโลยีนี้ถูกนำไปใช้ในทางที่ผิดหรือเป็นอันตราย

Chris Cox จาก Meta เล่าถึงความท้าทายเหล่านี้ว่า “มีคนบอกว่าเราบ้าไปแล้ว ที่จะลงทุนเทรนโมเดลและแจกฟรี” แต่ Meta เองก็เคยเป็นสตาร์ทอัพที่พึ่งพา open source เป็นฐานรากในการพัฒนาเทคโนโลยี ดังนั้นความเชื่อมั่นในพลังของชุมชนและการพัฒนาร่วมกันจึงเป็นแรงผลักดันสำคัญ

สิ่งที่น่าสนใจคือในปัจจุบัน แนวคิด open source AI ได้รับการยอมรับอย่างกว้างขวางในระดับรัฐบาลและอุตสาหกรรมเทคโนโลยี เนื่องจากมีข้อดีเรื่องความโปร่งใส การตรวจสอบได้ และสามารถปรับแต่งให้เหมาะสมกับการใช้งานเฉพาะด้านได้อย่างมีประสิทธิภาพ

ความสำเร็จของ Llama และแรงสนับสนุนจากชุมชน

Llama 4 เป็นจุดเปลี่ยนสำคัญที่แสดงให้เห็นว่าโมเดล AI แบบ open source สามารถแข่งขันกับโมเดลปิดได้อย่างไร โดยมีสถิติที่น่าทึ่งคือมียอดดาวน์โหลดถึง 1.2 พันล้านครั้งในเวลาเพียงสิบสัปดาห์หลังเปิดตัว

นอกจากโมเดลหลักแล้ว ยังมีโมเดลอนุพันธ์ (derivative models) จำนวนมากที่นักพัฒนาสร้างขึ้นเพื่อตอบโจทย์เฉพาะทาง เช่น การรองรับภาษาท้องถิ่นหรือการใช้งานในแอปพลิเคชันเฉพาะด้าน

ความสำเร็จนี้เกิดขึ้นจากความร่วมมือกับพันธมิตรหลากหลายกลุ่ม ซึ่งช่วยให้ผู้ใช้สามารถเริ่มใช้งาน Llama ได้ง่ายและยืดหยุ่น ผ่านสแต็กที่เป็นโมดูลาร์ ทำให้นักพัฒนาสามารถเลือกใช้เฉพาะส่วนที่เหมาะสมกับงานของตน

คุณสมบัติเด่นของ Llama 4

- MOE (Mixture of Experts) Model: สถาปัตยกรรมแบบ sparse ที่เพิ่มประสิทธิภาพโดยเปิดใช้งานเพียงส่วนหนึ่งของโมเดล ทำให้ได้ประสิทธิภาพสูงในขนาดโมเดลที่เล็กลง

- Multimodal: รองรับการป้อนข้อมูลทั้งข้อความและภาพในโมเดลเดียวกัน ทำให้เร็วและแม่นยำกับงานที่ต้องวิเคราะห์ภาพและข้อความร่วมกัน

- Multilingual: รองรับภาษาได้ถึง 200 ภาษาและใช้โทเคนภาษาหลายสิบเท่าจากรุ่นก่อนหน้า

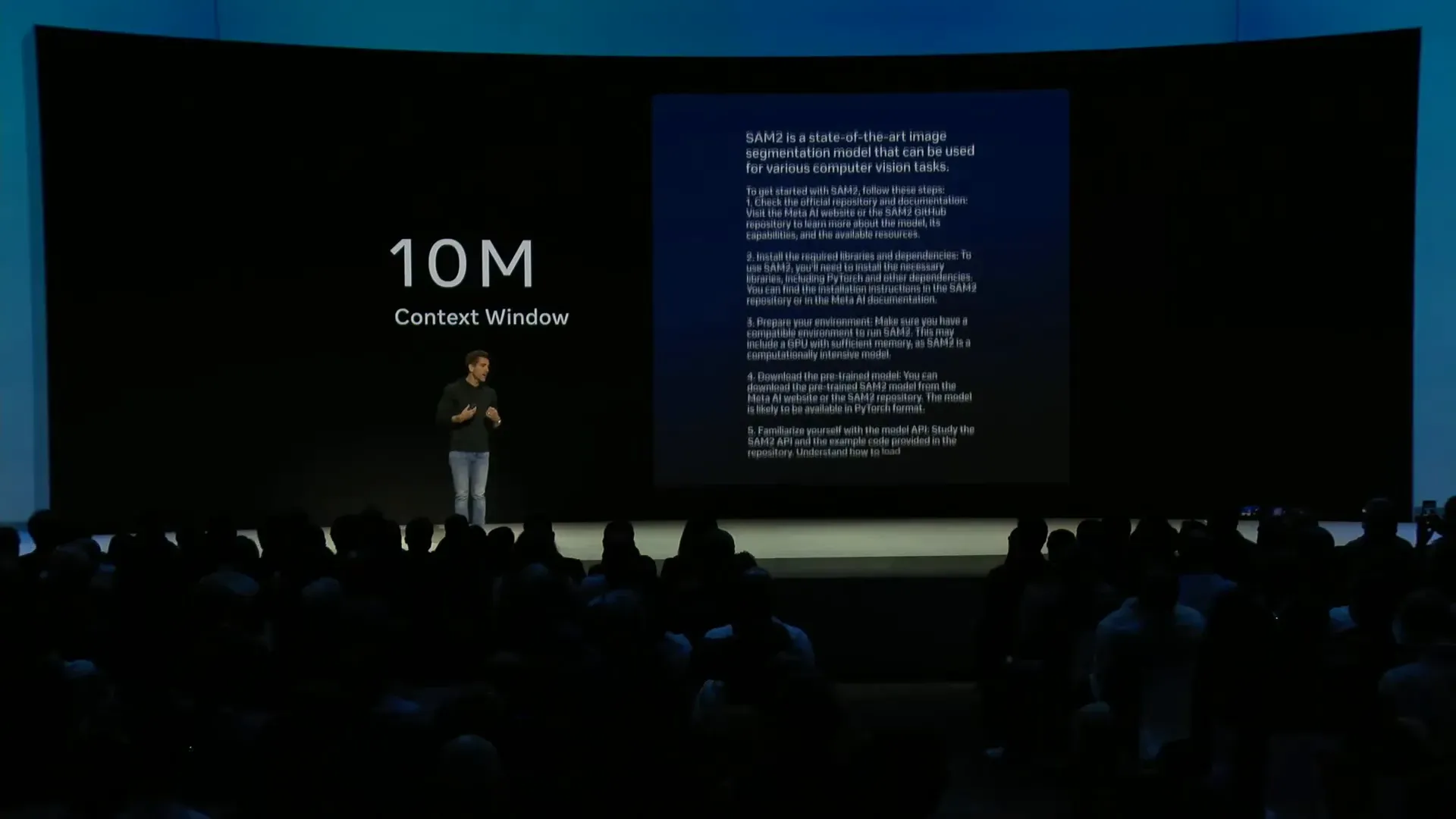

- Context Window ขนาดใหญ่: สามารถใส่ข้อมูลจำนวนมากในบริบท เช่น โค้ดโปรแกรมทั้งหมด หรือแม้แต่กฎหมายภาษีสหรัฐอเมริกา

- ประสิทธิภาพสูงและขนาดเล็ก: รุ่น Scout ที่เล็กที่สุดสามารถรันบนฮาร์ดแวร์ระดับ single H100 และรุ่น Maverick ที่ 17 พันล้านพารามิเตอร์รันบน 8 GPU เหมาะสำหรับการใช้งานจริงในผลิตภัณฑ์ Meta AI

Meta AI App และประสบการณ์เสียงที่เป็นธรรมชาติ

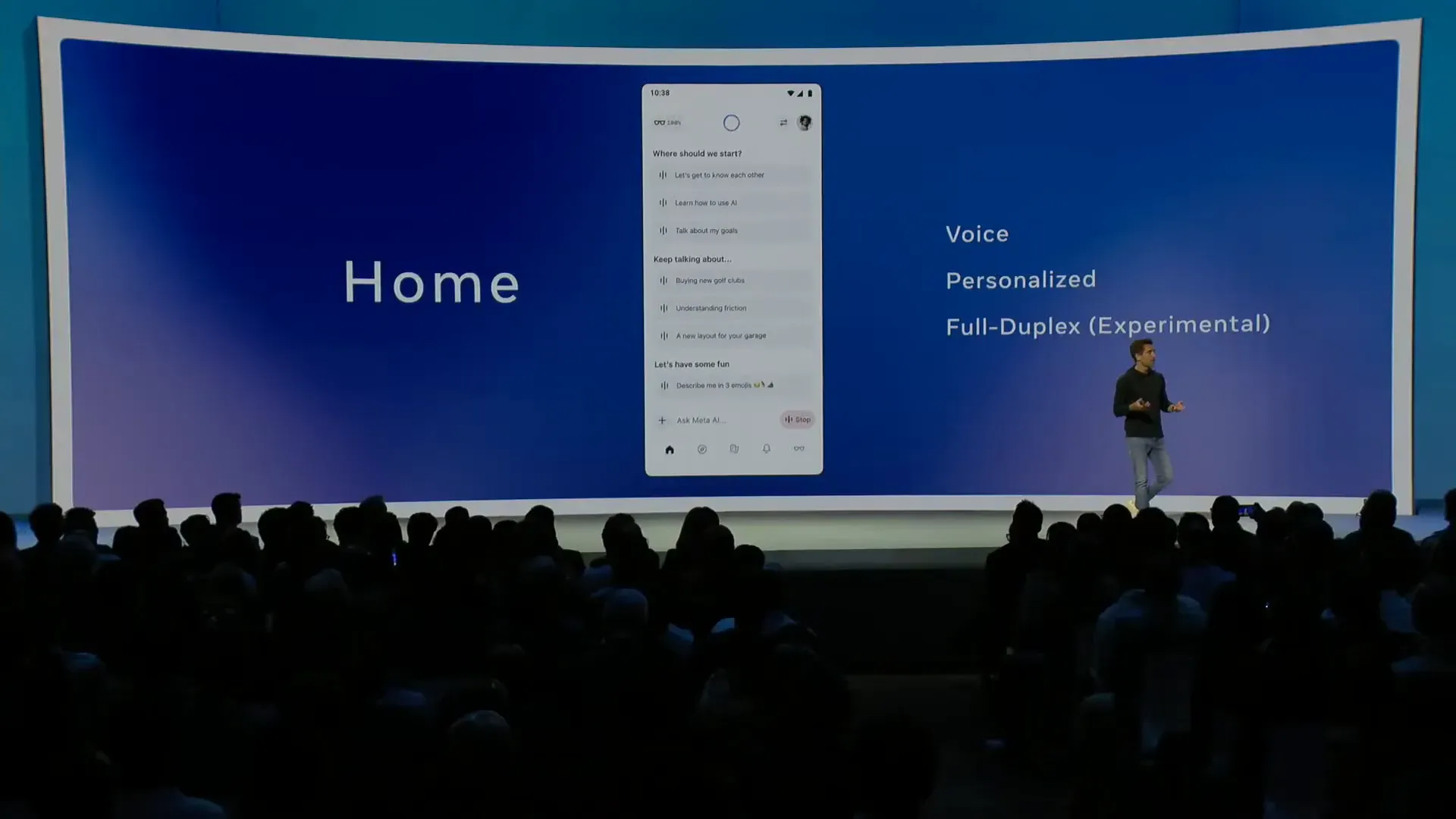

Meta ได้เปิดตัวแอป AI ใหม่ที่เน้นประสบการณ์การใช้งานด้วยเสียง (voice experience) ที่สื่อสารได้อย่างเป็นธรรมชาติและรวดเร็ว ระบบนี้สามารถเชื่อมต่อกับบัญชี Facebook และ Instagram เพื่อปรับแต่งการตอบสนองตามความสนใจและความทรงจำส่วนตัว เช่น ชื่อสมาชิกในครอบครัว หรือวันเกิด

ฟีเจอร์ที่โดดเด่นคือ full duplex voice ที่ให้การสนทนาแบบสองทิศทางเหมือนโทรศัพท์จริง ๆ รวมถึงเสียงหัวเราะและการแทรกซ้อนในบทสนทนา ซึ่งทำให้การโต้ตอบกับ AI รู้สึกเป็นธรรมชาติและสนุกสนานยิ่งขึ้น แม้ในช่วงแรกฟีเจอร์นี้ยังไม่รองรับการใช้งานเครื่องมือหรือค้นหาเว็บ แต่ก็เป็นการเปิดโอกาสให้เห็นศักยภาพของเทคโนโลยีใหม่

นอกจากนี้ แอปยังสนับสนุนการแบ่งปันคำสั่ง (prompts) และผลงานสร้างสรรค์ เช่น งานศิลปะหรือโค้ดโปรแกรม เพื่อสร้างชุมชนที่มีความคิดสร้างสรรค์และช่วยกันเรียนรู้

การผสานกับ Ray-Ban AI Glasses

Ray-Ban AI Glasses เป็นอุปกรณ์ AI แบบ multimodal ที่ได้รับความนิยมสูง สามารถถามคำถามเกี่ยวกับสิ่งที่เห็นผ่านเลนส์ได้อย่างรวดเร็วด้วยเสียง แอป Meta AI จึงได้รับการออกแบบให้สอดคล้องและใช้งานร่วมกับอุปกรณ์เหล่านี้ได้อย่างราบรื่น

กรณีศึกษาและการนำไปใช้งานจริงของ Llama

การนำ Llama ไปใช้งานในสถานการณ์จริงมีหลากหลายและน่าประทับใจ เช่น

- การใช้งานบนสถานีอวกาศนานาชาติ: Booz Allen และ ISS ใช้ Llama 3 เพื่อช่วยนักบินอวกาศค้นหาข้อมูลจากเอกสารและคู่มือจำนวนมาก โดยไม่ต้องพึ่งพาการเชื่อมต่อกับโลกภายนอก

- ภาคการแพทย์และสุขภาพ: Sofia ในละตินอเมริกาและ Mayo Clinic ใช้ Llama เพื่อลดเวลาการทำงานเอกสารและช่วยวินิจฉัยโรค โดยเฉพาะในด้านรังสีวิทยา

- เกษตรกรรมในแอฟริกาตะวันออก: Farmer Chat ให้ข้อมูลและคำแนะนำเกษตรกรด้วยภาษาท้องถิ่นและการสนับสนุนภาษาเฉพาะ

- ตลาดรถมือสองในละตินอเมริกาและตะวันออกกลาง: Kavac ใช้ Llama ในการสนับสนุนลูกค้าผ่านการปรับแต่งโมเดลที่เหมาะสมกับภูมิภาค

- ธุรกิจขนาดใหญ่: AT&T ใช้ Llama ในการวิเคราะห์บันทึกการสนทนาลูกค้า เพื่อระบุปัญหาและลำดับความสำคัญในการแก้ไขบั๊ก

API และการปรับแต่งโมเดล Llama ให้เหมาะกับงาน

Meta ได้เปิดตัว Llama API ที่ใช้งานง่ายและรวดเร็ว โดยสามารถเริ่มต้นด้วยโค้ดเพียงบรรทัดเดียว รองรับภาษา Python และ TypeScript รวมถึงสามารถใช้งานร่วมกับ OpenAI SDK ได้อย่างง่ายดาย

ฟีเจอร์สำคัญของ API ได้แก่

- รองรับ multimodal input เช่น ภาพและข้อความในคำขอเดียวกัน

- รองรับ JSON schema สำหรับการตอบกลับที่มีโครงสร้าง

- รองรับ tool calling ให้โมเดลสามารถเรียกใช้เครื่องมือเสริมได้อัตโนมัติ (อยู่ในสถานะพรีวิว)

- ให้ความสำคัญกับความปลอดภัยและความเป็นส่วนตัว โดยข้อมูลที่ส่งผ่าน API จะไม่ถูกนำไปใช้เทรนโมเดล

การปรับแต่งโมเดล (fine tuning) เป็นอีกหนึ่งจุดแข็งของ Llama API ที่ให้ผู้ใช้ควบคุมโมเดลลูกได้เต็มที่ สามารถดาวน์โหลดโมเดลที่เทรนเองและนำไปใช้งานที่ไหนก็ได้ ไม่ต้องล็อกอินกับเซิร์ฟเวอร์ของ Meta

ขั้นตอนการปรับแต่งโมเดล

- เปิดแท็บ Fine tuning และเริ่มงานใหม่

- อัปโหลดข้อมูลสำหรับการเทรน หรือใช้ข้อมูลที่เคยอัปโหลดแล้ว

- เลือกแบ่งชุดข้อมูลบางส่วนไว้สำหรับการประเมินผล

- ตั้งชื่อและตั้งค่าพารามิเตอร์ต่าง ๆ

- ติดตามความคืบหน้าของการเทรนผ่านการแสดงผล loss แบบเรียลไทม์

- เมื่อเทรนเสร็จ สามารถดาวน์โหลดโมเดลเพื่อนำไปใช้เอง หรือเรียกใช้ผ่าน Llama API

หลังการเทรน สามารถประเมินผลโมเดลได้โดยใช้ระบบ graders ที่ช่วยวัดประสิทธิภาพในด้านที่สนใจ เช่น ความถูกต้องของข้อมูล (factuality) และดูรายงานผลอย่างละเอียด

การให้บริการโมเดลและประสิทธิภาพการประมวลผล (Inference)

หนึ่งในความท้าทายสำคัญของการนำ AI ไปใช้จริงคือการให้บริการโมเดลที่มีประสิทธิภาพและต้นทุนต่ำ Llama 4 ถูกออกแบบมาโดยเน้นที่ประสิทธิภาพในการประมวลผล โดยเฉพาะรุ่น Maverick ที่ใช้สถาปัตยกรรม MOE (Mixture of Experts) ที่เปิดใช้งานเพียงส่วนหนึ่งของพารามิเตอร์ ทำให้ลดการใช้ทรัพยากรและเพิ่มความเร็ว

นอกจากนี้ยังมีการใช้เทคนิค quantization แบบ FP8 ซึ่งช่วยลดขนาดโมเดลและทำให้รันบนฮาร์ดแวร์เดี่ยวได้ง่ายขึ้น เช่น บนเซิร์ฟเวอร์ H100

ระบบ inference stack ใหม่ของ Llama ยังเพิ่มฟีเจอร์ speculative decoding ที่ใช้โมเดลขนาดเล็กช่วยร่างคำตอบล่วงหน้า ทำให้การสร้างคำตอบรวดเร็วขึ้น 1.5-2.5 เท่า รวมถึงเทคนิค paged KV เพื่อจัดการกับคำถามที่มีความยาวมาก

ล่าสุด Meta ประกาศความร่วมมือกับ Cerebras และ Grok เพื่อนำฮาร์ดแวร์ขั้นสูงมารองรับ Llama API เพิ่มความเร็วในการให้บริการและช่วยนักพัฒนาในการทดลองใช้งานก่อนขยายสเกล

เครื่องมือและเทคโนโลยีในสายตา FAIR สำหรับ AI ด้านการรับรู้ภาพ

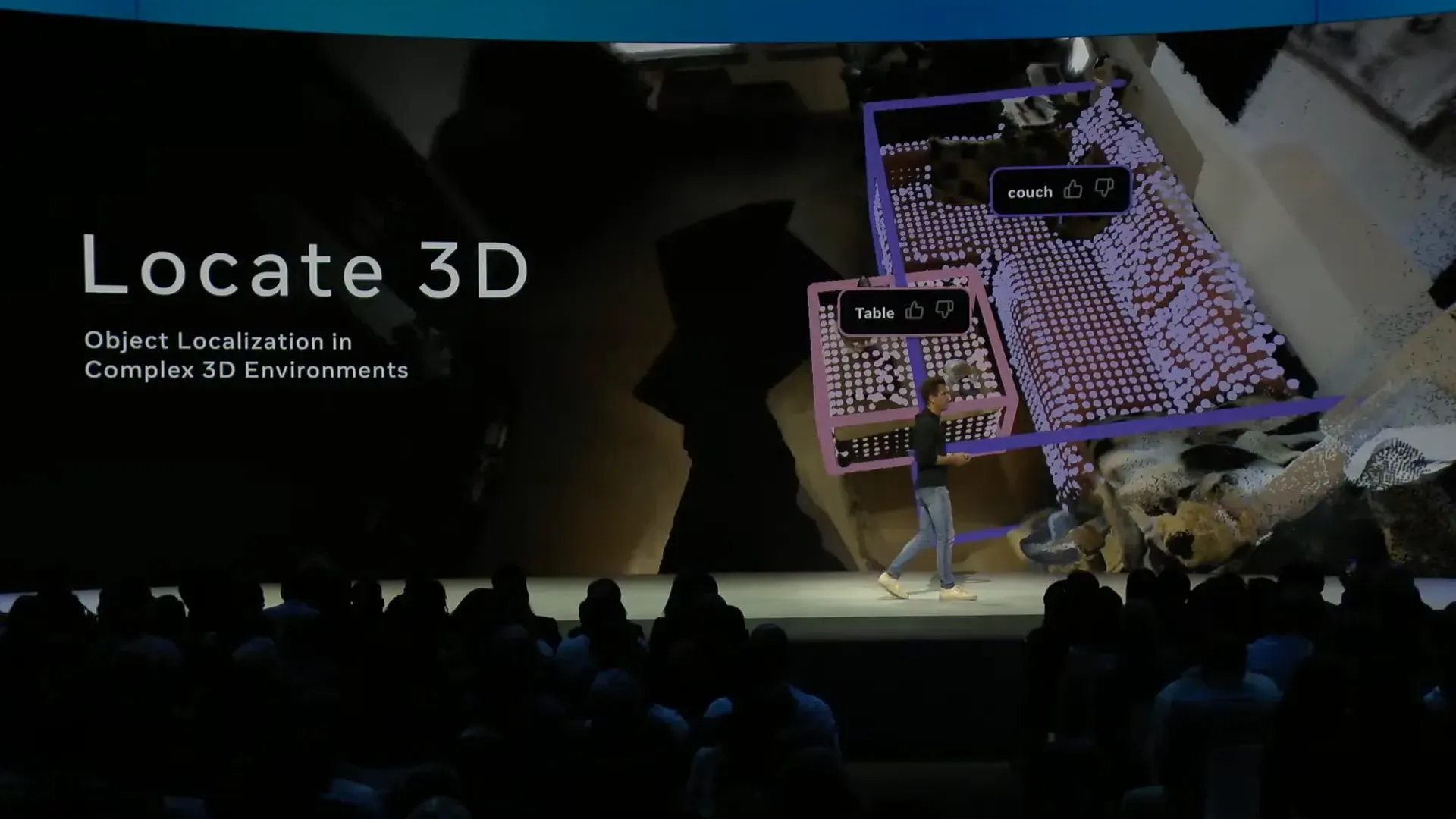

นอกจากโมเดลภาษาขนาดใหญ่ Llama ยังมีการพัฒนาเครื่องมือสำหรับ AI ด้านการรับรู้ภาพและวิดีโอ เช่น Locate3D ที่ช่วยระบุขอบเขตและวัตถุในสภาพแวดล้อมสามมิติด้วยคำสั่งข้อความ ซึ่งเหมาะกับการสร้างชุดข้อมูลและพัฒนาแอปพลิเคชันในโลกเสมือนจริง

เครื่องมือเหล่านี้ใช้ perception encoder ที่เป็น visual encoder ที่มีความยืดหยุ่นและพกพาง่าย เช่น SAM 2 ซึ่งเป็นระบบตรวจจับวัตถุที่ดีที่สุดในโลก และได้รับความนิยมอย่างมากในชุมชนวิทยาศาสตร์และงานสร้างสรรค์ เช่น Instagram Edits ที่เปิดตัวทั่วโลก

ข่าวดีคือ SAM 3 ที่จะมาในฤดูร้อนนี้ จะมีความก้าวหน้าอย่างมาก AWS จะเป็นผู้ให้บริการโฮสต์แบบ native สำหรับเครื่องมือเหล่านี้ ทำให้การใช้งานในโดเมนภาพเป็นไปอย่างรวดเร็วและมีความหน่วงต่ำ

ประสบการณ์จริงและการใช้งาน AI กับครอบครัว

Chris Cox เล่าเรื่องการทดลองใช้แอป Meta AI กับลูกชายวัย 10 ขวบ โดยเริ่มจากถามข่าวสารทั่วไปที่ลูกชายไม่สนใจ แต่เมื่อพูดถึงเรื่อง Dungeons and Dragons (D&D) ซึ่งเป็นเกมที่ลูกชายชื่นชอบ ความสนใจเปลี่ยนไปทันที เพราะ AI สามารถตอบคำถามเฉพาะทางเกี่ยวกับ D&D ได้อย่างลึกซึ้งและต่อเนื่อง ซึ่งสะท้อนให้เห็นถึงศักยภาพของ AI ที่สามารถปรับตัวเข้ากับความสนใจเฉพาะของผู้ใช้แต่ละคน

การสนทนาระหว่าง Mark Zuckerberg และ Ali Ghodsi: วิสัยทัศน์และแนวโน้มของ Open Source AI

ในช่วง Fireside Chat ระหว่าง Mark Zuckerberg และ Ali Ghodsi ผู้ก่อตั้ง Databricks ได้พูดคุยถึงแนวโน้มและโอกาสของ AI แบบเปิด โดย Ali เน้นถึงการเติบโตอย่างรวดเร็วของโมเดลขนาดเล็กที่มีประสิทธิภาพสูง เช่น Llama 3.3 รุ่น 70 พันล้านพารามิเตอร์ที่มีประสิทธิภาพเทียบเท่ารุ่นใหญ่ในปีที่ผ่านมา

Ali ยกตัวอย่างความสำเร็จของลูกค้าหลากหลาย เช่น Crisis Text Line ที่ใช้ Llama ตรวจจับความเสี่ยงของผู้โทรในสถานการณ์วิกฤตและช่วยเหลือได้อย่างแม่นยำ รวมถึงการใช้งานในตลาดการเงินที่ทำให้การสอบถามข้อมูลทางการเงินเป็นภาษาอังกฤษธรรมดาแทนการใช้ภาษาคิวรีที่ซับซ้อน

นวัตกรรมและเทคนิคสำคัญที่ช่วยขับเคลื่อน AI

- Mixture of Experts (MOE): ช่วยเพิ่มประสิทธิภาพและลดต้นทุนโดยการใช้งานพารามิเตอร์บางส่วนในแต่ละครั้ง

- Context Length ที่เพิ่มขึ้น: ช่วยให้โมเดลสามารถประมวลผลข้อมูลจำนวนมากในบริบทเดียว

- Reinforcement Learning on Customer Data: เทคนิคที่ Databricks เรียกว่า TAO ช่วยให้โมเดลเข้าใจและ reasoning บนข้อมูลเฉพาะของลูกค้าได้ดียิ่งขึ้น

- Distillation: การสกัดความรู้จากโมเดลขนาดใหญ่ไปยังโมเดลขนาดเล็กที่เหมาะสมกับการใช้งานเฉพาะทาง

Ali เน้นว่าโมเดลขนาดเล็กที่ถูก distill ลงมาอย่างเหมาะสมจะกลายเป็นที่นิยมมากกว่าโมเดลขนาดใหญ่ เนื่องจากความรวดเร็วและต้นทุนที่ต่ำกว่า เหมาะกับงานที่ต้องการ latency ต่ำ เช่น การช่วยเขียนโค้ดแบบ real-time

Mark Zuckerberg และ Ali ยังพูดถึงความสำคัญของเสียง (voice) ในการโต้ตอบกับ AI ในอนาคต ซึ่งจะกลายเป็นอินเทอร์เฟซหลักมากขึ้น โดยเฉพาะกับอุปกรณ์สวมใส่ เช่น แว่นตา AI ที่ให้การสื่อสารเป็นธรรมชาติและต่อเนื่อง

Open Source AI กับอนาคตของอุตสาหกรรม

ทั้งสองผู้บริหารเห็นตรงกันว่า open source AI จะเป็นหัวใจของนวัตกรรมในอนาคต เพราะช่วยลดต้นทุน เพิ่มความโปร่งใส และขยายโอกาสให้กับนักวิจัยและนักพัฒนาในวงกว้าง Ali เล่าว่าในมหาวิทยาลัยหลายแห่งรู้สึกถูกจำกัดจากโมเดลปิด ทำให้การวิจัยและพัฒนาล่าช้า

Open source AI ช่วยสร้างชุมชนที่แข็งแกร่งและกระตุ้นการแลกเปลี่ยนความรู้ นำไปสู่การพัฒนาโมเดลที่มีความสามารถหลากหลายและตอบโจทย์การใช้งานที่ต่างกัน

การผสมผสานและการปรับแต่งโมเดล

นอกจากการใช้โมเดลหลักแล้ว นักพัฒนายังสามารถนำโมเดลจากแหล่งต่าง ๆ มาผสมผสานและ distill เพื่อสร้างโมเดลที่เหมาะสมกับงานเฉพาะ เช่น การนำ reasoning capabilities จากโมเดลหนึ่งไปเสริมในโมเดล Llama

เทคนิค reinforcement learning และ distillation กำลังได้รับความนิยมมากขึ้น เนื่องจากช่วยให้โมเดลมีความแม่นยำและตอบโจทย์งานเฉพาะได้ดียิ่งขึ้นในต้นทุนที่ต่ำกว่า

ความปลอดภัยและความน่าเชื่อถือ

เรื่องความปลอดภัยเป็นสิ่งที่ต้องให้ความสำคัญ โดยเฉพาะเมื่อใช้โมเดลจากแหล่งต่างประเทศหรือโมเดลที่นำมาปรับแต่ง Ali และ Mark เน้นว่าต้องมีการตรวจสอบและควบคุมเพื่อป้องกันความเสี่ยง เช่น การแนะนำผลิตภัณฑ์คู่แข่งโดยไม่ตั้งใจ

เครื่องมืออย่าง LlamaGuard และ Code Shield ที่ Meta พัฒนาขึ้นมา เป็นตัวอย่างของความพยายามในการรักษาความปลอดภัยและความน่าเชื่อถือของโมเดล

ความหลากหลายของ AI Agents และบทบาทของมนุษย์

ในอนาคตจะมี AI Agents จำนวนมากที่ถูกพัฒนาขึ้นเพื่อตอบโจทย์ธุรกิจและผู้ใช้งานเฉพาะกลุ่ม เช่น ธุรกิจขนาดเล็กที่ต้องการ AI ในการดูแลลูกค้าผ่าน WhatsApp หรือแอปพลิเคชันต่าง ๆ

ความหลากหลายนี้จำเป็นเพื่อให้ AI สามารถตอบสนองความต้องการเฉพาะของแต่ละองค์กรได้ โดยไม่ต้องพึ่งพา AI เดียวที่อาจไม่เหมาะกับทุกสถานการณ์

อย่างไรก็ตาม มนุษย์ยังคงมีบทบาทสำคัญในการควบคุม ดูแล และตรวจสอบ AI Agents เหล่านี้ เพื่อให้มั่นใจว่าการตัดสินใจของ AI มีความถูกต้องและเหมาะสม

คำแนะนำสำหรับนักพัฒนา AI ในยุคใหม่

Mark Zuckerberg และ Ali Ghodsi ต่างเน้นย้ำว่า AI ยังคงอยู่ในช่วงเริ่มต้น (Day Zero) ของยุคใหม่ที่เต็มไปด้วยโอกาสและนวัตกรรมที่ยังไม่ถูกค้นพบ

สิ่งที่สำคัญที่สุดคือการมี ข้อมูลที่ได้เปรียบ (data advantage) เพราะ AI จะเก่งขึ้นเมื่อได้รับข้อมูลเฉพาะที่เหมาะสมกับงานนั้น ๆ การสร้างระบบวนซ้ำ (flywheel) ที่เก็บข้อมูลและปรับปรุงโมเดลอย่างต่อเนื่องจะช่วยให้เกิดความได้เปรียบทางการแข่งขัน

นอกจากนี้ การสร้างชุดข้อมูลทดสอบ (evals) และเกณฑ์วัดประสิทธิภาพที่เหมาะสมกับการใช้งานจริง จะช่วยให้นักพัฒนารู้ว่าโมเดลของตนทำงานได้ดีแค่ไหนโดยไม่ต้องตรวจสอบทุกคำตอบด้วยตนเอง

สุดท้ายคือความกล้าที่จะทดลองและสร้างสรรค์ไอเดียใหม่ ๆ เพราะโลก AI ยังเปิดกว้างสำหรับนวัตกรรมที่ยังไม่เกิดขึ้นและยังไม่มีใครจินตนาการได้อย่างครบถ้วน

ศัพท์เทคนิคที่ควรรู้

- MOE (Mixture of Experts): สถาปัตยกรรมโมเดล AI แบบ sparse ที่เปิดใช้งาน expert บางส่วนในโมเดล ทำให้ลดการใช้ทรัพยากรและเพิ่มประสิทธิภาพ

- Distillation: กระบวนการถ่ายทอดความรู้จากโมเดลขนาดใหญ่ไปยังโมเดลขนาดเล็ก เพื่อให้โมเดลเล็กมีความสามารถใกล้เคียงกันในงานเฉพาะ

- Fine tuning: การปรับแต่งโมเดล AI ด้วยข้อมูลเฉพาะเพื่อให้เหมาะกับการใช้งานที่ต้องการ

- Speculative decoding: เทคนิคการเร่งความเร็วในการสร้างคำตอบโดยใช้โมเดลขนาดเล็กช่วยร่างคำตอบล่วงหน้าให้โมเดลหลัก

- Full duplex voice: การสื่อสารด้วยเสียงที่เปิดสองช่องทางพร้อมกัน ทำให้โต้ตอบได้เหมือนสนทนาโทรศัพท์จริง

บทสรุปจาก Insiderly

- การเปิดตัว Llama 4 และ Llama API ใน LlamaCon 2025 ถือเป็นก้าวสำคัญที่ยืนยันว่า AI แบบ open source ไม่เพียงแค่เป็นทางเลือก แต่กำลังกลายเป็นหัวใจของนวัตกรรม AI ในอนาคต

- ด้วยสถาปัตยกรรม MOE ที่ช่วยเพิ่มประสิทธิภาพและลดต้นทุน การรองรับ multimodal input และความสามารถในการปรับแต่งโมเดลอย่างเต็มรูปแบบ ทำให้ Llama ตอบโจทย์การใช้งานที่หลากหลาย ตั้งแต่แอปพลิเคชันบนมือถือจนถึงการใช้งานระดับองค์กรขนาดใหญ่

- ความร่วมมือกับพันธมิตรและการพัฒนาระบบ inference ที่มีประสิทธิภาพสูง ช่วยขยายขีดความสามารถในการให้บริการ AI ที่รวดเร็วและปลอดภัย ขณะที่การสนับสนุนด้านเสียงและอุปกรณ์สวมใส่เปิดโอกาสใหม่ ๆ ในการปฏิสัมพันธ์กับ AI

- ในมุมมองของนักพัฒนาและองค์กร การมีข้อมูลที่ได้เปรียบและความสามารถในการ fine tuning โมเดลตามงานเฉพาะ ถือเป็นกุญแจสำคัญที่จะก้าวข้ามขีดจำกัดของ AI แบบเดิม ๆ และสร้างประสบการณ์ที่ตอบโจทย์จริงในโลกธุรกิจและชีวิตประจำวัน

- สุดท้ายนี้ การที่ AI จะไม่เป็นเพียงผู้ช่วยเดียว แต่จะมีความหลากหลายของ AI Agents ที่ตอบสนองความต้องการเฉพาะของแต่ละธุรกิจและผู้ใช้ เป็นภาพสะท้อนของอนาคตที่ AI จะกลายเป็นส่วนหนึ่งของชีวิตและการทำงาน

ดังนั้นจึงเป็นเวลาที่ดีที่สุดสำหรับนักพัฒนาและองค์กรทุกขนาดที่จะเริ่มต้นสร้างสรรค์และทดลองใช้ AI แบบเปิด เพื่อก้าวเข้าสู่ยุคใหม่ของนวัตกรรมที่ไม่มีขีดจำกัด